先週に引き続き顔ランドマーク推定に関わる論文として、CVPR2020で提案された LUVLi Face Alignment: Estimating Landmarks’ Location, Uncertainty, and Visibility Likelihood (arXiv) を紹介します。

LUVLi Face Alignment: Estimating Landmarks’ Location, Uncertainty, and Visibility Likelihood

@misc{kumar2020luvli,

title={LUVLi Face Alignment: Estimating Landmarks' Location, Uncertainty, and Visibility Likelihood},

author={Abhinav Kumar and Tim K. Marks and Wenxuan Mou and Ye Wang and Michael Jones and Anoop Cherian and Toshiaki Koike-Akino and Xiaoming Liu and Chen Feng},

year={2020},

eprint={2004.02980},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

モチベーション

顔ランドマークの位置だけではなく、uncertainty (不確実性) とvisibility (視認性) も同時に正確に予測したいというのがメインテーマとなります。見づらい・見えないランドマークは、その度合いも評価することが後続タスクにとって有益な情報となります。

光源やピンボケ、遮蔽 (手やマスクなどによるocclusionと顔向きによるself-occlusion) などによってランドマークの判別しづらい場合は、分散を大きくするというのがゴールとなります。

ヒートマップ回帰の問題点

不確実性と視認性を正確に予測する上で、現在主流のヒートマップ回帰は大きく2つの問題を抱えています。

- 固定対称ガウス分布をground-truthとして学習しているため、予測されたヒートマップが不確実性の予測には適していない

- 例えば、顎のランドマークはフェイスラインに沿った分布になるはず (なのに学習ではそれが表現できていない)

- リサイズされたヒートマップに対してargmaxを行って、ランドマークとなる1ピクセルを決定するため、量子化誤差が発生する

提案

- Location, Uncertainty, and Visibility Likelihood (LUVLi) によるモデル化

- 非遮蔽・遮蔽・自己遮蔽 (self-occluded) が区別された19000枚以上の顔画像からなるデータセット

LUVLi

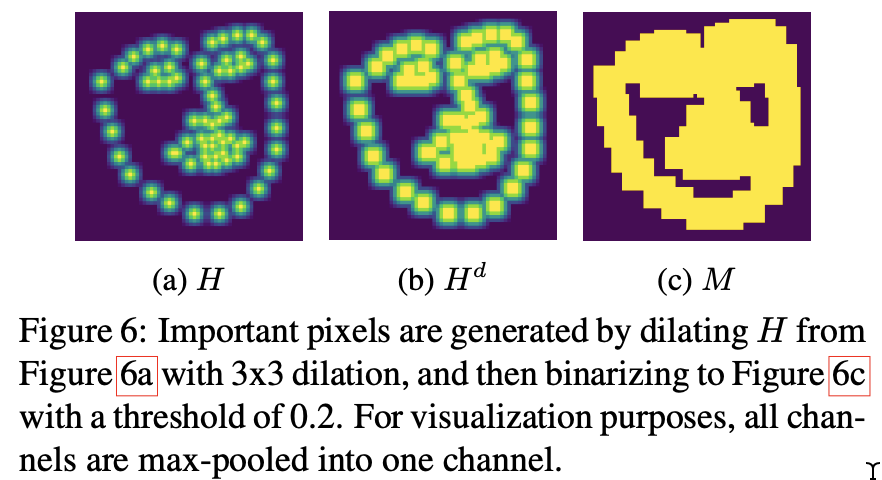

LUVLiではDU-Net3をベースとし、各U-netから分岐する3つのコンポネントを追加したモデルとなっています。いずれも微分可能でend-to-endで学習可能です。

- Mean Estimator: ランドマークの位置を推定

- 各ランドマークのヒートマップをReLUに通して加重平均することでサブピクセルの精度の推定結果を得られる

- CEN (Cholesky Estimator Network) : ランドマーク位置の共分散行列のコレスキー係数を推定

- 重みは全U-netで共有

- VEN (Visibility Estimator Network) : ランドマークの視認性の確率を推定

- 重みは全U-netで共有

LUVLiのロス関数は以下で定めている。

- 第1項・第2項がvisibilityについてのバイナリクロスエントロピ

- visibleなら

となる分類

- visibleなら

- 第3項がランドマーク座標 (

) についての対数尤度

- 位置推定の回帰

- μが期待値ベクトル、Σが分散共分散行列で、求めたいパラメータとなる

CENとVENはそれぞれDU-Netのボトルネックを入力として全結合している。

- CENは、分散共分散行列

を

(コレスキー分解) したときの下三角行列Lの3つの値を出力とする

- VENは、sigmoidで[0, 1]の確率値を出力とする

MERL-RAV

AFLW4の約19000枚の画像に対して、各ランドマーク座標に新たに以下3つのvisibilityクラスを付与したデータセット MERL Reannotation of AFLW with Visibility (MERL-RAV) を提案。

- Unoccluded: 遮蔽なし (見える)

- Self-occluded: 顔の角度によってランドマークが隠れている

- Externally occluded: 髪や手、帽子などによってランドマークが隠れている

LUVLiではUnoccludedとExternally occludedを 、Self-occludedを

としてます。(確かに画像に写っていない裏側のランドマークを付けるなんて本来は不可能なはず。)

実験

NME、AUC、FRで評価。

- visibility

が0のときは誤差の計算に含めない

- 正解座標

に対して、予測座標

はU-Net最終層の出力

300-W, Menpo, COFWにおける他モデルとの比較

それぞれSotAを達成してますが、externally occludedが多く含まれるCOFWで特筆して高い値をマークしており、遮蔽への強さが示されてます。

また300-Wのtestセットを使って、残差と分散共分散行列値の相関を調べたところ、一定の条件下で高い相関が見られました。これによって、分散共分散行列の予測値で不確かさを表現できていることがわかります。

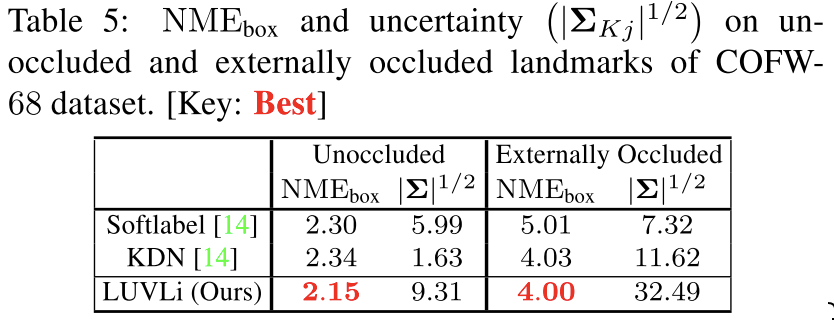

COFWを使って遮蔽有無に依る分散共分散行列の値の変動を調べた結果が以下の表です。LUVLiでは遮蔽されている場合に十分大きな値となることがわかります。

CENについて、ヒートマップベースの手法も調査したが、直接座標を回帰する方法と比べてうまくいかなかった。分散共分散行列の最小固有値の分布を見ると、ほとんどが1ピクセル以下で、64x64のヒートマップでは解像度が低すぎるためとのことです。

MERL-RAVを使った評価

LULViの特性をさらにMERL-RAVで詳細に調べた結果が以下です。

- 特に顔向き (yaw) の角度が大きいHalf-ProfileとProfileで素のDU-Netよりも高い精度をマークしてます

- 遮蔽有無によって、Σの値も大きくなっており、不確かさを表す予測値として機能しています

所感

「遮蔽されているランドマークは、遮蔽されていることがわかるようにする」「遮蔽されているランドマークの位置を "敢えて" 推定するなら、どの程度分散するのかわかるようにする」という実利用では避けて通れない問題を、シンプルにアプローチした研究かと思いました。

-

Diogo Luvizon, David Picard, and Hedi Tabia. 2D/3D pose estimation and action recognition using multitask deep learn- ing. In CVPR, 2018.↩

-

Ying Tai, Yicong Liang, Xiaoming Liu, Lei Duan, Jilin Li, Chengjie Wang, Feiyue Huang, and Yu Chen. Towards highly accurate and stable face alignment for high-resolution videos. In AAAI, 2019.↩

-

Zhiqiang Tang, Xi Peng, Kang Li, and Dimitris Metaxas. Towards efficient U-Nets: A coupled and quantized approach. TPAMI, 2019.↩

-

Martin Koestinger, Paul Wohlhart, Peter Roth, and Horst Bischof. Annotated facial landmarks in the wild: A large-scale, real-world database for facial landmark localization. In ICCVWorkshops, 2011.↩